最近花些時間學(xué)習(xí)了一下Python,并寫了一個多線程的爬蟲程序來獲取電影天堂上資源的迅雷下載地址,代碼已經(jīng)上傳到GitHub上了,需要的同學(xué)可以自行下載。剛開始學(xué)習(xí)python希望可以獲得寶貴的意見。

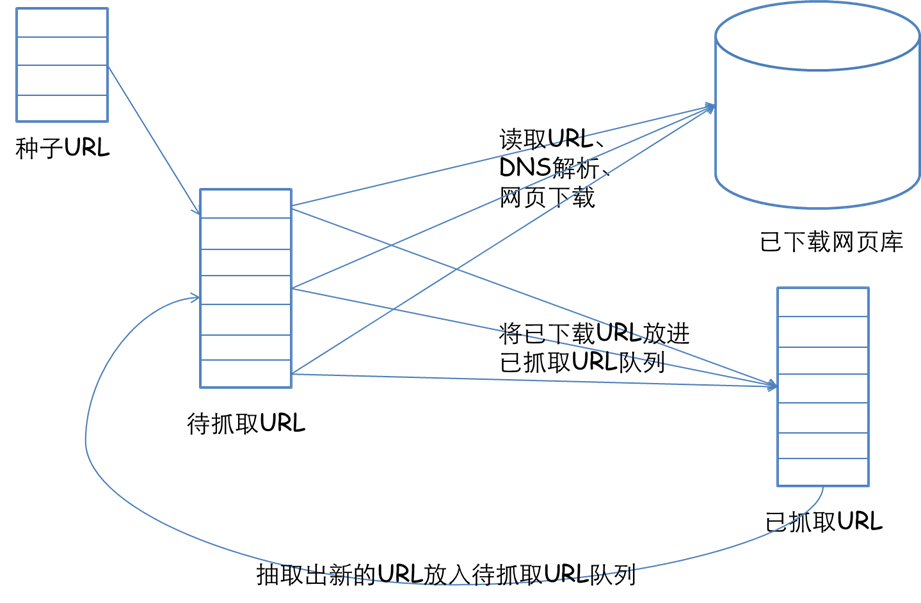

先來簡單介紹一下,網(wǎng)絡(luò)爬蟲的基本實現(xiàn)原理吧。一個爬蟲首先要給它一個起點,所以需要精心選取一些URL作為起點,然后我們的爬蟲從這些起點出發(fā),抓取并解析所抓取到的頁面,將所需要的信息提取出來,同時獲得的新的URL插入到隊列中作為下一次爬取的起點。這樣不斷地循環(huán),一直到獲得你想得到的所有的信息爬蟲的任務(wù)就算結(jié)束了。我們通過一張圖片來看一下。

好的 下面進入正題,來講解下程序的實現(xiàn)。

首先要分析一下電影天堂網(wǎng)站的首頁結(jié)構(gòu)。

從上面的菜單欄中我們可以看到整個網(wǎng)站資源的總體分類情況。剛剛好我們可以利用到它的這個分類,將每一個分類地址作為爬蟲的起點。

①解析首頁地址 提取分類信息

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

#解析首頁def CrawIndexPage(starturl):print "正在爬取首頁"page = __getpage(starturl)if page=="error":returnpage = page.decode('gbk', 'ignore')tree = etree.HTML(page)Nodes = tree.xpath("//div[@id='menu']//a")print "首頁解析出地址",len(Nodes),"條"for node in Nodes:CrawledURLs = []CrawledURLs.append(starturl)url=node.xpath("@href")[0]if re.match(r'/html/[A-Za-z0-9_/]+/index.html', url):if __isexit(host + url,CrawledURLs):passelse:try:catalog = node.xpath("text()")[0].encode("utf-8")newdir = "E:/電影資源/" + catalogos.makedirs(newdir.decode("utf-8"))print "創(chuàng)建分類目錄成功------"+newdirthread = myThread(host + url, newdir,CrawledURLs)thread.start()except:pass |

在這個函數(shù)中,首先將網(wǎng)頁的源碼下載下來,通過XPath解析出其中的菜單分類信息。并創(chuàng)建相應(yīng)的文件目錄。有一個需要注意的地方就是編碼問題,但是也是被這個編碼糾纏了好久,通過查看網(wǎng)頁的源代碼,我們可以發(fā)現(xiàn),網(wǎng)頁的編碼采用的是GB2312,這里通過XPath構(gòu)造Tree對象是需要對文本信息進行解碼操作,將gb2312變成Unicode編碼,這樣DOM樹結(jié)構(gòu)才是正確的,要不然在后面解析的時候就會出現(xiàn)問題。

②解析每個分類的主頁

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

|

# 解析分類文件def CrawListPage(indexurl,filedir,CrawledURLs):print "正在解析分類主頁資源"print indexurlpage = __getpage(indexurl)if page=="error":returnCrawledURLs.append(indexurl)page = page.decode('gbk', 'ignore')tree = etree.HTML(page)Nodes = tree.xpath("//div[@class='co_content8']//a")for node in Nodes:url=node.xpath("@href")[0]if re.match(r'/', url):# 非分頁地址 可以從中解析出視頻資源地址if __isexit(host + url,CrawledURLs):passelse:#文件命名是不能出現(xiàn)以下特殊符號filename=node.xpath("text()")[0].encode("utf-8").replace("/"," ")\.replace("\\"," ")\.replace(":"," ")\.replace("*"," ")\.replace("?"," ")\.replace("\""," ")\.replace("<", " ") \.replace(">", " ")\.replace("|", " ")CrawlSourcePage(host + url,filedir,filename,CrawledURLs)passelse:# 分頁地址 從中嵌套再次解析print "分頁地址 從中嵌套再次解析",urlindex = indexurl.rfind("/")baseurl = indexurl[0:index + 1]pageurl = baseurl + urlif __isexit(pageurl,CrawledURLs):passelse:print "分頁地址 從中嵌套再次解析", pageurlCrawListPage(pageurl,filedir,CrawledURLs)passpass |

打開每一個分類的首頁會發(fā)現(xiàn)都有一個相同的結(jié)構(gòu)(點擊打開示例)首先解析出包含資源URL的節(jié)點,然后將名稱和URL提取出來。這一部分有兩個需要注意的地方。一是因為最終想要把資源保存到一個txt文件中,但是在命名時不能出現(xiàn)一些特殊符號,所以需要處理掉。二是一定要對分頁進行處理,網(wǎng)站中的數(shù)據(jù)都是通過分頁這種形式展示的,所以如何識別并抓取分頁也是很重要的。通過觀察發(fā)現(xiàn),分頁的地址前面沒有“/”,所以只需要通過正則表達式找出分頁地址鏈接,然后嵌套調(diào)用即可解決分頁問題。

③解析資源地址保存到文件中

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

#處理資源頁面 爬取資源地址def CrawlSourcePage(url,filedir,filename,CrawledURLs):print urlpage = __getpage(url)if page=="error":returnCrawledURLs.append(url)page = page.decode('gbk', 'ignore')tree = etree.HTML(page)Nodes = tree.xpath("//div[@align='left']//table//a")try:source = filedir + "/" + filename + ".txt"f = open(source.decode("utf-8"), 'w')for node in Nodes:sourceurl = node.xpath("text()")[0]f.write(sourceurl.encode("utf-8")+"\n")f.close()except:print "!!!!!!!!!!!!!!!!!" |

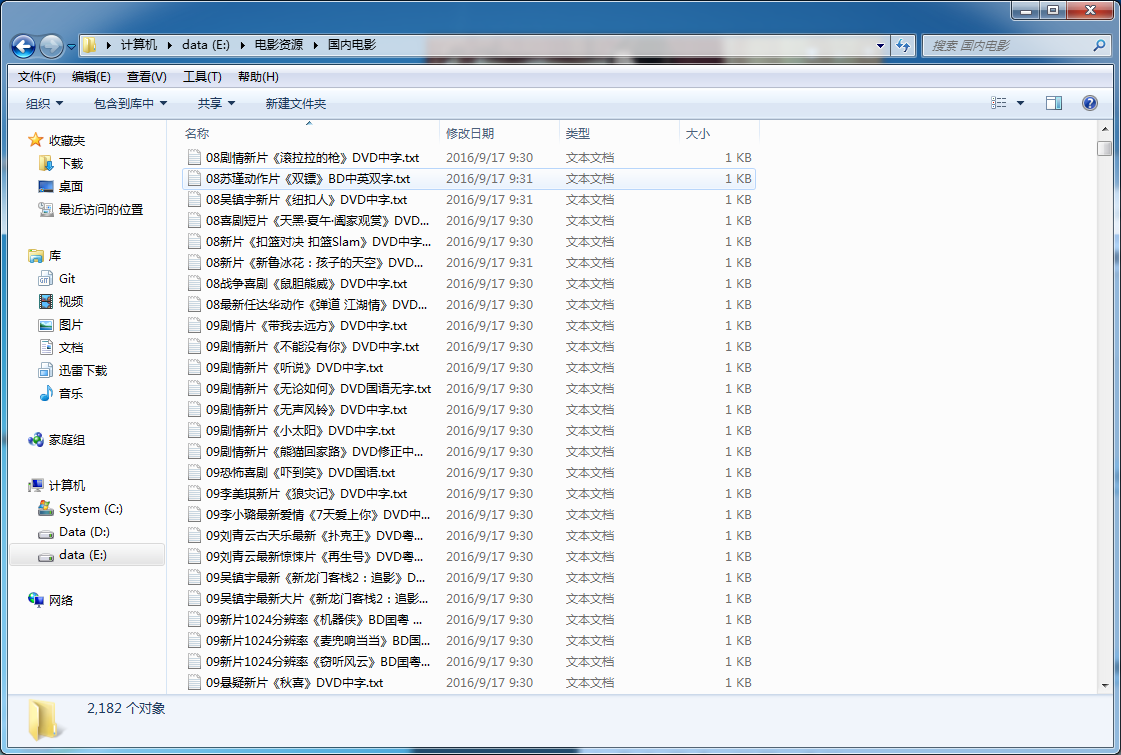

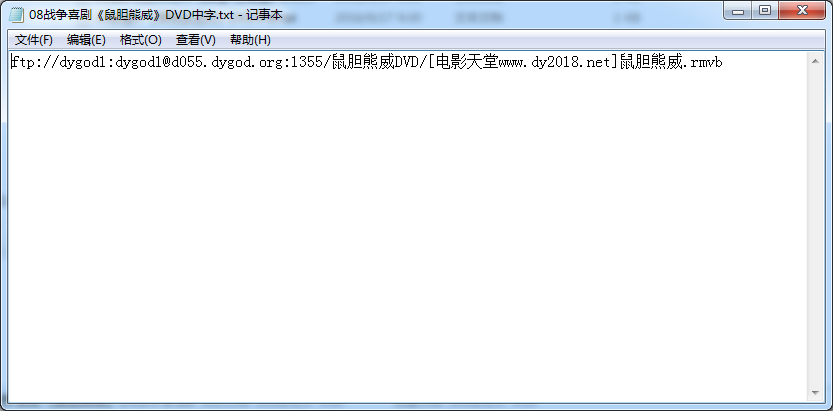

這段就比較簡單了,將提取出來的內(nèi)容寫到一個文件中就行了

為了能夠提高程序的運行效率,使用了多線程進行抓取,在這里我是為每一個分類的主頁都開辟了一個線程,這樣極大地加快了爬蟲的效率。想當(dāng)初,只是用單線程去跑,結(jié)果等了一下午最后因為一個異常沒處理到結(jié)果一下午都白跑了!!!!心累

|

1

2

3

4

5

6

7

8

|

class myThread (threading.Thread): #繼承父類threading.Threaddef __init__(self, url, newdir,CrawledURLs):threading.Thread.__init__(self)self.url = urlself.newdir = newdirself.CrawledURLs=CrawledURLsdef run(self): #把要執(zhí)行的代碼寫到run函數(shù)里面 線程在創(chuàng)建后會直接運行run函數(shù)CrawListPage(self.url, self.newdir,self.CrawledURLs) |

以上只是部分代碼,全部代碼可以到GitHub上面去下載(點我跳轉(zhuǎn))

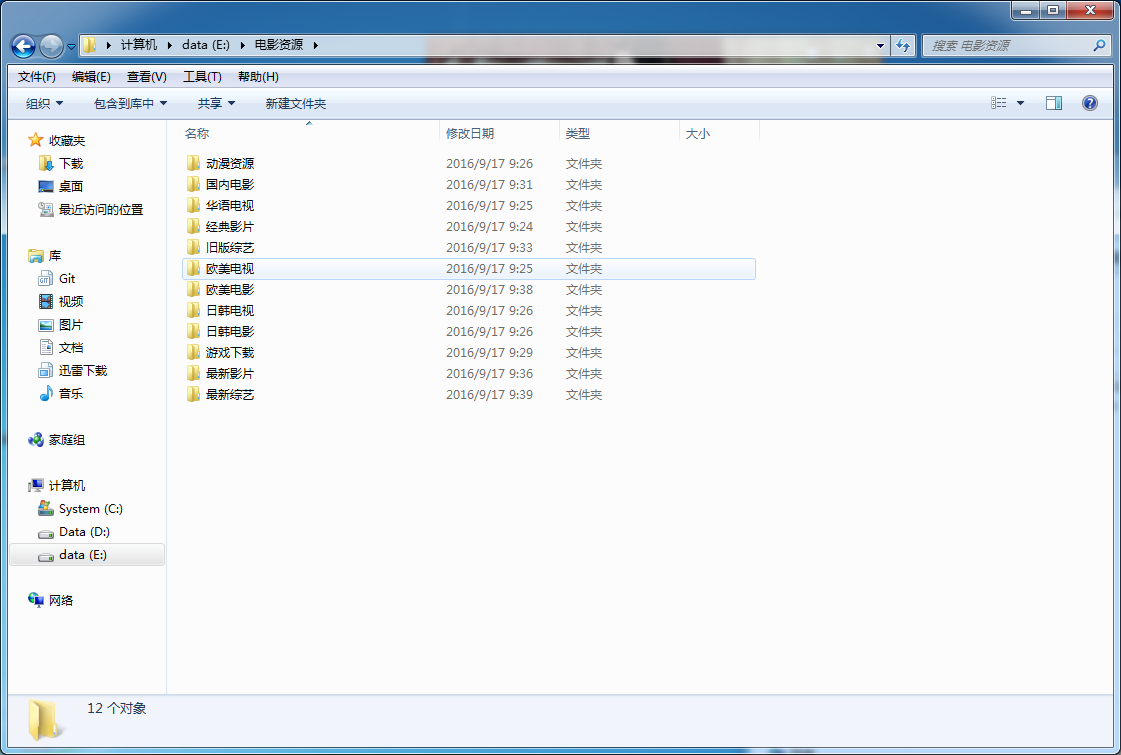

最后爬取的結(jié)果如下。

以上所述是小編給大家介紹的使用Python多線程爬蟲爬取電影天堂資源 ,希望對大家有所幫助,如果大家有任何疑問請給我留言,小編會及時回復(fù)大家的。在此也非常感謝大家對服務(wù)器之家網(wǎng)站的支持!