好吧,我知道是大半夜……,但我還是覺得趕緊花上半個小時,把這最新的想法分享出來是值得的~直接進入正題~

我們來模擬一個場景,需要你去抓去一個頁面,然后這個頁面有好多url也要分別去抓取,而進入這些子url后,還有數據要抓取。簡單點,我們就按照三層來看,那我們的代碼就是如下:

def func_top(url):

data_dict= {}

#在頁面上獲取到子url

sub_urls = xxxx

data_list = []

for it in sub_urls:

data_list.append(func_sub(it))

data_dict[\'data\'] = data_list

return data_dict

def func_sub(url):

data_dict= {}

#在頁面上獲取到子url

bottom_urls = xxxx

data_list = []

for it in bottom_urls:

data_list.append(func_bottom(it))

data_dict[\'data\'] = data_list

return data_dict

def func_bottom(url):

#獲取數據

data = xxxx

return data

func_top是上層頁面的處理函數,func_sub是子頁面的處理函數,func_bottom是最深層頁面的處理函數,func_top會在取到子頁面url后遍歷調用func_sub,func_sub也是同樣。

如果正常情況下,這樣確實已經滿足需求了,但是偏偏這個你要抓取的網站可能極不穩定,經常鏈接不上,導致數據拿不到。

于是這個時候你有兩個選擇:

1.遇到錯誤就停止,之后重新從斷掉的位置開始重新跑

2.遇到錯誤繼續,但是要在之后重新跑一遍,這個時候已經有的數據不希望再去網站拉一次,而只去拉沒有取到的數據

對第一種方案基本無法實現,因為如果別人網站的url調整順序,那么你記錄的位置就無效了。那么只有第二種方案,說白了,就是要把已經拿到的數據cache下來,等需要的時候,直接從cache里面取。

OK,目標已經有了,怎么實現呢?

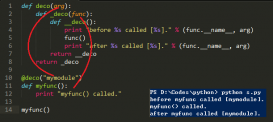

如果是在C++中的,這是個很麻煩的事情,而且寫出來的代碼必定丑陋無比,然而慶幸的是,我們用的是python,而python對函數有裝飾器。

所以實現方案也就有了:

定義一個裝飾器,如果之前取到數據,就直接取cache的數據;如果之前沒有取到,那么就從網站拉取,并且存入cache中.

代碼如下:

def get_dump_data(dir_name, url):

m = hashlib.md5(url)

filename = m.hexdigest()

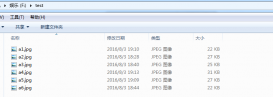

full_file_name = \'dumps/%s/%s\' % (dir_name,filename)

if os.path.isfile(full_file_name):

return eval(file(full_file_name,\'r\').read())

else:

return None

def set_dump_data(dir_name, url, data):

if not os.path.isdir(\'dumps/\'+dir_name):

os.makedirs(\'dumps/\'+dir_name)

m = hashlib.md5(url)

filename = m.hexdigest()

full_file_name = \'dumps/%s/%s\' % (dir_name,filename)

f = file(full_file_name, \'w+\')

f.write(repr(data))

f.close()

def deco_dump_data(func):

def func_wrapper(url):

data = get_dump_data(func.__name__,url)

if data is not None:

return data

data = func(url)

if data is not None:

set_dump_data(func.__name__,url,data)

return data

return func_wrapper

然后,我們只需要在每個func_top,func_sub,func_bottom都加上deco_dump_data這個裝飾器即可~~

搞定!這樣做最大的好處在于,因為top,sub,bottom,每一層都會dump數據,所以比如某個sub層數據dump之后,是根本不會走到他所對應的bottom層的,減少了大量的開銷!

OK,就這樣~ 人生苦短,我用python!