本文環(huán)境是python3,采用的是urllib,BeautifulSoup搭建。

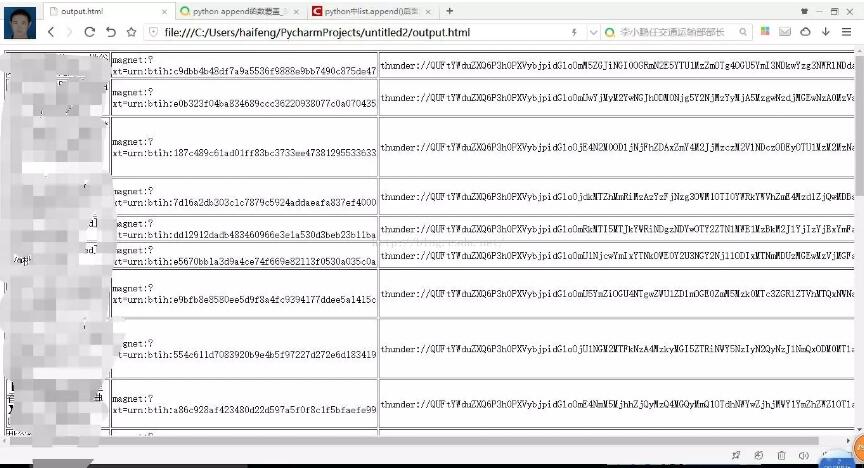

說下思路,這個項目分為管理器,url管理器,下載器,解析器,html文件生產(chǎn)器。各司其職,在管理器進行調(diào)度。最后將解析到的種子連接生產(chǎn)html文件顯示。當然也可以保存在文件。最后效果如圖。

首先在管理器SpiderMain()這個類的構(gòu)造方法里初始化下載器,解析器,html生產(chǎn)器。代碼如下。

|

1

2

3

4

5

6

|

def__init__(self): self.urls = url_manager.UrlManager() self.downloader = html_downloader.HtmlDownloader() self.parser = html_parser.HtmlParser() self.outputer = html_outputer.HtmlOutputer() |

然后在主方法里寫入主連接并開始下載解析和輸出。

|

1

2

3

4

5

6

|

if __name__ == '__main__': url = "http://www.btany.com/search/桃谷繪里香-first-asc-1" # 解決中文搜索問題 對于:?=不進行轉(zhuǎn)義 root_url = quote(url,safe='/:?=') obj_spider = SpiderMain() obj_spider.parser(root_url) |

用下載器進行下載,解析器解析下載好的網(wǎng)頁,最后輸出。管理器的框架邏輯就搭建完畢

|

1

2

3

4

|

def parser(self, root_url): html = self.downloader.download(root_url) datas = self.parser.parserTwo(html) self.outputer.output_html3(datas) |

downloader下載器代碼如下:

|

1

2

3

4

5

6

7

8

9

10

11

|

def download(self, chaper_url): if chaper_url is None: return None headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:23.0) Gecko/20100101 Firefox/23.0'} req = urllib.request.Request(url=chaper_url, headers=headers) response = urllib.request.urlopen(req) if response.getcode() != 200: return None return response.read() |

headers是模仿瀏覽器的請求頭。不然下載不到html文件。

解析器代碼如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

# 解析種子文件def parserTwo(self,html): if html is None: return soup = BeautifulSoup(html,'html.parser',from_encoding='utf-8') res_datas = self._get_data(soup) return res_datas# 將種子文件的標題,磁力鏈接和迅雷鏈接進行封裝def _get_data(self,soup): res_datas = [] all_data = soup.findAll('a',href=re.compile(r"/detail")) all_data2 = soup.findAll('a', href=re.compile(r"magnet")) all_data3 = soup.findAll('a',href=re.compile(r"thunder")) for i in range(len(all_data)): res_data = {} res_data['title'] = all_data[i].get_text() res_data['cl'] = all_data2[i].get('href') res_data['xl'] = all_data3[i].get('href') res_datas.append(res_data) return res_datas |

通過分析爬下來的html文件,種子鏈接在a標簽下。然后提取magnet和thunder下的鏈接。

最后輸出器輸出html文件,代碼如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

def __init__(self): self.datas = []def collect_data(self, data): if data is None: return self.datas.append(data)#輸出表單 def output_html3(self,datas): fout = open('output.html', 'w', encoding="utf-8") fout.write("<html>") fout.write("<head><meta http-equiv="content-type" content="text/html;charset=utf-8"></head>") fout.write("<body>") fout.write("<table border = 1>") for data in datas: fout.write("<tr>") fout.write("<td>%s</td>" % data['title']) fout.write("<td>%s</td>" % data['cl']) fout.write("<td>%s</td>" % data['xl']) fout.write("</tr>") fout.write("</table>") fout.write("</body>") fout.write("</html>") fout.close() |

項目就結(jié)束了。源代碼已上傳,鏈接https://github.com/Ahuanghaifeng/python3-torrent,覺得有用請在github上給個star,您的鼓勵將是作者創(chuàng)作的動力。

以上這篇python3爬取torrent種子鏈接實例就是小編分享給大家的全部內(nèi)容了,希望能給大家一個參考,也希望大家多多支持服務器之家。

原文鏈接:https://blog.csdn.net/u013692888/article/details/52660492