Kafka是由Apache軟件基金會開發一個開源流處理平臺,使用Scala和Java編寫, 該項目的目標是為處理實時數據提供一個統一、高吞吐、低延遲的平臺。其持久化層本質上是一個按照分布式事務日志架構的大規模發布/訂閱消息隊列。這種工作方式使它為企業級基礎設施來處理流失數據非常有價值。

本文的目的是使用Docker容器來部署Kafka, 這樣可以省略Kafka安裝配置的中間過程, 節省大量時間。文章中分別從幾個維度來闡述Kafka的部署過程, 包括:基礎環境要求、安裝zookeeper、容器內的設置等, 最后給出了一個從生產者角度向消費者發送消息, 消費者成功接收到消息作為結尾, 最后給出了一個在全過程當中遇到問題排查的正確方法。

認識Kafka

Kafka存儲的消息來自任務多被稱為"生產者"(Producer)的進程。數據從而可以被分配到不同的"分區"(Partition)、不同的“Topic”下。在一個分區內, 消息被索引并連同時間戳存儲在一起。而其它被稱為"消費者"(Consumer)的進程可以從分區查詢消息。Kafka運行在一個由一臺或多臺服務器組成的集群上, 并且分區可以跨集群節點分布。Kafka的架構如下圖所示:

以下列出了Kafka技術相關的術語:

- Topic - 用來對消息進行分類, 每個進入到Kafka的信息都會被放到一個Topic下。

- Broker - 用來實現數據存儲的主機服務器。

- Partition - 每個Topic中的消息會被分為若干個Partition,以提高消息的處理效率

- Producer - 消息的生產者

- Consumer - 消息的消費者

了解了以上概念之后,對于Kafka的部署已經沒有什么障礙, 下面開始正式的部署過程。

基礎環境準備

大多數Linux發行版都支持安裝Kafka,這里我準備了一臺ubuntu 22.04.3 LTS版本的虛擬機作為試驗環境。

登錄到系統輸入:docker -v 命令, 如果出現:

Docker version 24.0.5, build 24.0.5-0ubuntu1~22.04.1類似于這樣的提示信息,說明Docker已安裝,如果沒有,請輸入以下命令安裝Docker:

$ sudo apt update

$ sudo apt install docker.io

安裝zookeeper

由于Kafka依賴Zookeeper實現高可用性和一致性,其為Kafka提供了關鍵的分布式協調服務,因此部署Kafka必須先部署Zookeeper集群作為基礎, 以下進入部署Zookeeper的過程:

在命令行直接輸入以下命令,docker會自動拉取對應鏡像:

# docker run -d --name zookeeper -p 2181:2181 -v /etc/localtime:/etc/localtime wurstmeister/zookeeper拉取過程如圖:

安裝Kafka

Zookeeper安裝成功后, 接著安裝Kafka組件, 在命令行直接輸入以下命令,docker會自動拉取對應鏡像:

# docker run -d --name kafka -p 9092:9092 -e KAFKA_BROKER_ID=0 -e KAFKA_ZOOKEEPER_CONNECT=[你的IP地址]:2181 -e KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://[你的IP地址]:9092 -e KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092 -t wurstmeister/kafka注意, 我的服務器IP是192.168.201.206,所以上面的IP要根據自己的實際情況進行變更,我變更后的命令如下:

# docker run -d --name kafka -p 9092:9092 -e KAFKA_BROKER_ID=0 -e KAFKA_ZOOKEEPER_CONNECT=192.168.201.206:2181 -e KAFKA_ADVERTISED_LISTENERS=PLAINTEXT://192.168.201.206:9092 -e KAFKA_LISTENERS=PLAINTEXT://0.0.0.0:9092 -t wurstmeister/kafka拉取過程如圖:

進入容器

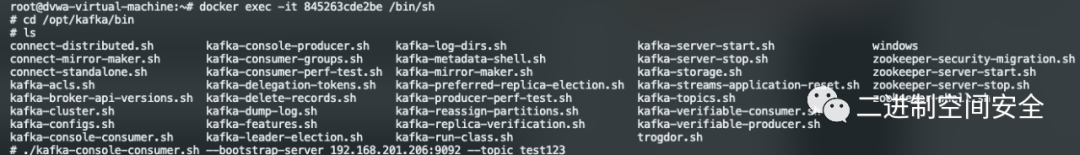

Kafka安裝完畢后,還要進入到容器中啟動生產者和消費者,這樣可以驗證kafka功能是否正常,順序執行命令如下:

# docker ps -a #查看kafka鏡像的容器ID

# docker exec -it 容器ID /bin/sh #進入到容器內部

# cd /opt/kafka/bin # 切到容器內部kafka執行目錄下執行最后的結果如圖:

啟動生產者

在容器里執行以下命令啟動生產者:

./kafka-console-producer.sh --broker-list localhost:9092 --topic [你的topic名稱]我這里自己起了一個topic名稱,名字為test123, 如圖:

產生者腳本啟動成功后,會有一個">"提示符。

啟動消費者

為了看到生產者和消費者之間的消息傳遞效果,這里需要另開一個終端,按照上面的方法進入容器對應目錄,并執行以下命令:

./kafka-console-consumer.sh --bootstrap-server [你的IP地址]:9092 --topic [你的topic名稱]注意,這里有兩個變量需要自己調整,一個是IP地址,另一個是上面建立的Topic名稱, 我這里填入信息后的完整命令如下:

./kafka-console-consumer.sh --bootstrap-server 192.168.201.206:9092 --topic test123執行過程如圖:

生產者與消費者測試

切換到生產者窗口,連續輸入一些信息,如圖:

再切換回消費者窗口, 正常的話已經可以收到生產者發送的信息了,如圖:

1故障排查

如果在使用Docker過程中遇到任何錯誤, 可以命令:

docker logs 容器ID通過查看容器日志進行故障排查,過程如圖:

總結

在部署Kafka的整個過程中, 遵循以下部署順序流程:

- 首先檢查Docker安裝是否正常, 確保Docker安裝無任何異常。

- 其次安裝Kafka的依賴服務Zookeeper, 只需要一句命令可實現自動鏡像拉取。

- 接著安裝Kafka組件,也是一句命令即可搞定, 自動拉取對應的鏡像。

- 進入到容器內部, 分別啟動生產者和消費者腳本, 便可以開始進行發送消息測試了。

- 在整個部署過程中,遇到任何錯誤或問題都可以通過Docker日志進行問題排查。