分布式數據庫(tencent distributed sql,tdsql)是騰訊打造的一款分布式數據庫產品,具備強一致高可用、全球部署架構、分布式水平擴展、高性能、企業級安全等特性,同時提供智能 dba、自動化運營、監控告警等配套設施,為客戶提供完整的分布式數據庫解決方案。

tdsql按照官方要求配置相對較高,現通過4臺虛擬機演示tdsql的全套部署。 如有不對的地方請指證 wx:moonstar00

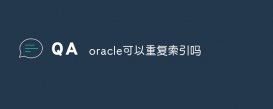

** 機器數量規劃:**

tdsql 規劃機器如下:4臺(cpu:2core/mem:8g/hdd:50g) ,內存至少5g以上 ,cpu 至少2c以上, 否則檢查通不過

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

|

#######################tdsql安裝部署#######################1.設主機名hostnamectl set-hostname huyidb01hostnamectl set-hostname huyidb02hostnamectl set-hostname huyidb03hostnamectl set-hostname huyidb042.配置主機名vim /etc/hosts10.85.10.51 huyidb0110.85.10.52 huyidb0210.85.10.53 huyidb0310.85.10.54 huyidb043.設置時間同步以huyidb01為主時鐘mount /dev/cdrom /mntyum -y install ntp*[root@huyidb01 ~]# vim /etc/ntp.conf#同步地址server 127.127.1.0 iburstsystemctl restart ntpd.service[root@huyidb02 ~]# vim /etc/ntp.confserver 10.85.10.51restrict 10.85.10.51 mask 255.255.240.0 nomodify notrapsystemctl restart ntpd.servicentpdate -u 10.85.10.51[root@huyidb03 ~]# vim /etc/ntp.confserver 10.85.10.51restrict 10.85.10.51 mask 255.255.240.0 nomodify notrapsystemctl restart ntpd.servicentpdate -u 10.85.10.51[root@huyidb04 ~]# vim /etc/ntp.confserver 10.85.10.51restrict 10.85.10.51 mask 255.255.240.0 nomodify notrapsystemctl restart ntpd.servicentpdate -u 10.85.10.514.配置免密登錄(管理機 110.85.10.54 上操作)ssh-keygen -t rsa --這里不用輸入密碼,免密碼登錄ssh-copy-id 10.85.10.51 --下面要輸入遠程主機的密碼ssh-copy-id 10.85.10.52ssh-copy-id 10.85.10.53ssh-copy-id 10.85.10.54#這里是通過ip copy的 ,測試的時候也只要用ip 例: ssh 10.85.10.515.準備數據目錄路徑(所有機器)mkdir -p /mysql/datamkdir -p /mysql/log |

|

1

2

3

4

|

#安裝ansibleunzip tdsql_full_install_ansible.zipcd tdsql_full_install_ansiblepython settings/install_ansible.py |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

|

#配置tdsql_hostsvi /soft/tdsql_full_install_ansible/tdsql_hosts[envcheck]tdsql_huyidb01 ansible_ssh_host=10.85.10.51tdsql_huyidb02 ansible_ssh_host=10.85.10.52tdsql_huyidb03 ansible_ssh_host=10.85.10.53tdsql_huyidb04 ansible_ssh_host=10.85.10.54[zk]tdsql_zk1 ansible_ssh_host=10.85.10.51tdsql_zk2 ansible_ssh_host=10.85.10.52tdsql_zk3 ansible_ssh_host=10.85.10.53[scheduler]tdsql_scheduler1 ansible_ssh_host=10.85.10.52tdsql_scheduler2 ansible_ssh_host=10.85.10.53[oss]tdsql_oss1 ansible_ssh_host=10.85.10.52tdsql_oss2 ansible_ssh_host=10.85.10.53[chitu]tdsql_chitu1 ansible_ssh_host=10.85.10.52tdsql_chitu2 ansible_ssh_host=10.85.10.53[monitor]tdsql_monitor1 ansible_ssh_host=10.85.10.52tdsql_monitor1 ansible_ssh_host=10.85.10.53[db]tdsql_db1 ansible_ssh_host=10.85.10.51tdsql_db2 ansible_ssh_host=10.85.10.52tdsql_db3 ansible_ssh_host=10.85.10.53[proxy]tdsql_proxy1 ansible_ssh_host=10.85.10.51tdsql_proxy2 ansible_ssh_host=10.85.10.52tdsql_proxy3 ansible_ssh_host=10.85.10.53[hdfs]tdsql_hdfs1 ansible_ssh_host=10.85.10.54[lvs]tdsql_lvs1 ansible_ssh_host=10.85.10.52tdsql_lvs2 ansible_ssh_host=10.85.10.53[kafka]tdsql_kafka1 ansible_ssh_host=10.85.10.51tdsql_kafka2 ansible_ssh_host=10.85.10.52tdsql_kafka3 ansible_ssh_host=10.85.10.53[consumer]tdsql_consumer1 ansible_ssh_host=10.85.10.54[es]tdsql_es1 ansible_ssh_host=10.85.10.54[newdb]tdsql_newdb1 ansible_ssh_host=1.1.1.1tdsql_newdb2 ansible_ssh_host=2.2.2.2tdsql_newdb3 ansible_ssh_host=3.3.3.3修改 ansible 變量vi /soft/tdsql_full_install_ansible/group_vars/allzk_num: 3netif_name: ens38 #<—填入 scheduler(ifconfig 看到的)網卡的名稱tdsql_pass: a+complex+passwordzk_rootdir: /tdsqlzk#下面參數后面安裝相關模塊時在調整metadb_ip: 10.120.109.204metadb_port: 15001metadb_ip_bak: 10.120.109.205metadb_port_bak: 15001metadb_user: hanlonmetadb_password: hanlonssh_port: 36000hdfs_datadir: /data2/hdfs,/data3/hdfs,/data4/hdfskafka_logdir: /data2/kafka,/data3/kafka,/data4/kafkaes_mem: 8es_log_days: 7es_base_path: /data/application/es-install/estdsql_secret_pass: k2jatuv5llbbmrske/k2ybqcoc_secret_pass: lghvs0v5nvxcolqie/k9bb2iclouddba_metadb_pass: h5wyg2xy |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

|

#執行安裝 part1_site.ymlsh encrypt.sh <---------必須執行,更新密文密碼ansible-playbook -i tdsql_hosts part1_site.yml執行了近20多分鐘 ,執行完成要無failed=0play recap ********************************************************************************************************************************************************chitu1 : ok=20 changed=19 unreachable=0 failed=0chitu2 : ok=20 changed=19 unreachable=0 failed=0db1 : ok=13 changed=12 unreachable=0 failed=0db2 : ok=13 changed=12 unreachable=0 failed=0db3 : ok=13 changed=12 unreachable=0 failed=0huyidb01 : ok=30 changed=19 unreachable=0 failed=0huyidb02 : ok=27 changed=16 unreachable=0 failed=0huyidb03 : ok=27 changed=16 unreachable=0 failed=0huyidb04 : ok=27 changed=17 unreachable=0 failed=0oss1 : ok=14 changed=11 unreachable=0 failed=0oss2 : ok=14 changed=11 unreachable=0 failed=0proxy1 : ok=13 changed=10 unreachable=0 failed=0proxy2 : ok=13 changed=10 unreachable=0 failed=0proxy3 : ok=13 changed=10 unreachable=0 failed=0scheduler1 : ok=25 changed=23 unreachable=0 failed=0scheduler2 : ok=22 changed=20 unreachable=0 failed=0zk1 : ok=19 changed=17 unreachable=0 failed=0zk2 : ok=19 changed=17 unreachable=0 failed=0zk3 : ok=19 changed=17 unreachable=0 failed=0 |

#錯誤:

task [zk_cluster : upload the template file zk_configure.py to the dst host] ************************************************************************************************************************************************************

fatal: [tdsql_zk1]: failed! => {“changed”: false, “msg”: “ansibleundefinedvariable: “hostvars[‘zk1']” is undefined”}

fatal: [tdsql_zk2]: failed! => {“changed”: false, “msg”: “ansibleundefinedvariable: “hostvars[‘zk1']” is undefined”}

fatal: [tdsql_zk3]: failed! => {“changed”: false, “msg”: “ansibleundefinedvariable: “hostvars[‘zk1']” is undefined”}

to retry, use: --limit @/soft/tdsql_full_install_ansible/part1_site.retry

原因: tdsql_hosts 配置標簽不規范 , 版本不同,標簽有所不同. 具體的參考模板,只改ip)

解決辦法: tdsql_zk1 改為 zk1

|

1

2

3

4

5

6

7

|

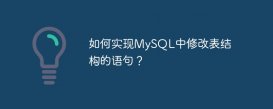

#初始化chituhttp://10.85.10.52/tdsqlpcloud注意這里的oss ip ,可能不是實際ip可以查看cat /data/application/oss/conf/scheduler.xml或 netstat 查看[root@huyidb02 ~]# netstat -an | grep 8080tcp 0 0 192.168.58.131:8080 0.0.0.0:* listen |

|

1

2

3

4

5

|

注意這里的oss ip ,可能不是實際ip可以查看cat /data/application/oss/conf/scheduler.xml或 netstat 查看[root@huyidb02 ~]# netstat -an | grep 8080tcp 0 0 192.168.58.131:8080 0.0.0.0:* listen |

|

1

2

3

4

5

6

|

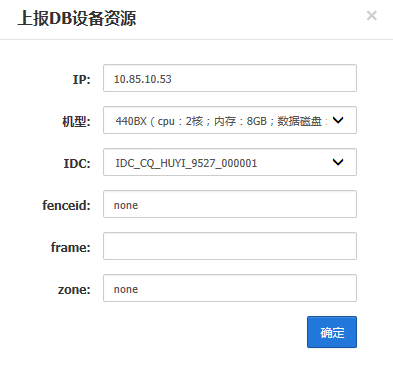

機型查看:[root@huyidb02 data]# dmidecode | grep “product name”product name: vmware virtual platformproduct name: 440bx desktop reference platform#db機型 這里填 440bx |

注意:不同db要在不同的idc

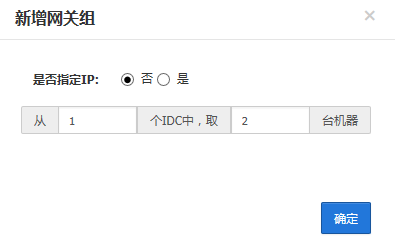

同一個網關組的要在同一個idc中

登錄運營管理平臺:帳號密碼admin/123456

|

1

2

3

4

5

6

7

8

|

測試登錄[root@huyidb02 data]# mysql -utdsqlpcloud -h10.85.10.52 -p15001 -p'tdsqlpcloud'welcome to the mariadb monitor. commands end with ; or \g.your mysql connection id is 3171server version: 5.7.17-11-v2.0r540d002-20191226-1152-log source distributioncopyright © 2000, 2018, oracle, mariadb corporation ab and others.type ‘help;' or ‘\h' for help. type ‘\c' to clear the current input statement.mysql [(none)]> |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

|

在管理庫修改vi /soft/tdsql_full_install_ansible/group_vars/allmetadb_ip: 10.85.10.52metadb_port: 15001metadb_ip_bak: 10.85.10.53metadb_port_bak: 15001metadb_user: tdsqlpcloudmetadb_password: tdsqlpcloud執行安裝 part2_site.ymlsh encrypt.sh <---------必須執行,更新密文密碼ansible-playbook -i tdsql_hosts part2_site.yml注意:failed=0play recap ********************************************************************************************************************************************************chitu1 : ok=19 changed=16 unreachable=0 failed=0chitu2 : ok=5 changed=4 unreachable=0 failed=0huyidb01 : ok=18 changed=11 unreachable=0 failed=0huyidb02 : ok=18 changed=11 unreachable=0 failed=0huyidb03 : ok=18 changed=11 unreachable=0 failed=0huyidb04 : ok=18 changed=11 unreachable=0 failed=0monitor1 : ok=12 changed=12 unreachable=0 failed=0oss1 : ok=14 changed=9 unreachable=0 failed=0oss2 : ok=14 changed=9 unreachable=0 failed=0scheduler1 : ok=31 changed=26 unreachable=0 failed=0scheduler2 : ok=22 changed=18 unreachable=0 failed=0#在任意一臺 scheduler 機器上執行下面的命令:cd /data/application/scheduler/bin./agent_config --mode modify --option=“ocagent_port” --value=“8966”./agent_config --mode modify --option=“hadoop_dir” --value="/data/home/tdsql/hadoop-3.2.1/bin" |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

#安裝備用赤兔(如果有另一個未初始化的 chitu)將已初始化的 chitu 機器上拷貝 2 個文件到未初始化的 chitu 機器上,并刪除未初始化 chitu 機器上的 crontab,如下:10.85.10.52 已初始化 chitu10.85.10.53 未初始化 chitu(1)在 52 機器上,拷貝文件到 53 機器上scp -p /data/website/tdsqlpcloud/www/config/database.php 10.85.10.53:/data/website/tdsqlpcloud/www/config/scp -p /data/website/tdsqlpcloud/www/config/install.lock 10.85.10.53:/data/website/tdsqlpcloud/www/config/(2)刪除 53 機器上 nginx 用戶的 crontabcp -a /var/spool/cron/nginx /data/tools/nginx_cron_bakrm -f /var/spool/cron/nginx(3)測試,登錄 53 的 chituhttp://10.85.10.53/tdsqlpcloud至此tdsql的基本模塊已安裝完成。 |

安裝其它模塊(可選)

安裝以下模塊之前要確保tdsql核心模塊安裝無誤后再進行。

如果需要使用hdfs異地冷備存儲binlog和鏡像文件,用于數據回檔恢復,安裝hdfs。

如果需要使用tdsql默認提供的接入層lvs,安裝lvs。

如果需要使用多源同步功能,安裝kafka和consumer。

如果需要使用網關日志分析及sql審計功能,安裝es。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

|

#安裝 hdfs(1)準備 hdfs 的數據目錄的路徑首先用 lsblk 查看磁盤信息格式化為 xfs 文件系統mkfs.xfs -f /dev/sdg創建目錄mkdir -p /mysql/backup修改/etc/fstab 文件,設置自動掛載到指定路徑/dev/sdg /mysql/backup xfs defaults,noatime 0 0掛載磁盤mount -a(2)設置主機名在 hdfs 機器上設置主機名,hdfs 集群中主機名不能重復,不能有下劃線、中劃線等特殊字符,hostnamectl set-hostname huyidb04(3)檢查 tdsql_hosts 文件vim tdsql_hosts[hdfs] <—填入 hdfs 機器地址,hdfs 的數量只能是 1 或 3hdfs1 ansible_ssh_host=10.85.10.54(4)修改 hdfs 變量修改 group_vars/all 中下面的相關變量vim group_vars/all—ssh_port: 36000 <----實際的 ssh 通信端口hdfs_datadir: /mysql/backup <----多個迪特 一個磁盤一個路徑,逗號分隔注意這些數據文件路徑的權限要是 tdsql,如下:chown -r tdsql:users /mysql/backup(5)#安裝 hdfs 單點 (我的是單點hdfs)執行安裝ansible-playbook -i tdsql_hosts hdfs_single.ymlsu - tdsqlhdfs namenode -format <—格式化 namenode啟動 namenode 和 datanode :hdfs --daemon start namenodehdfs --daemon start datanode附:用 tdsql 用戶關閉 hdfs 進程 :hdfs --daemon stop datanodehdfs --daemon stop namenode(6)#安裝 hdfs 高可用架構 (如果是高可用 用下面的方式安裝)3 個節點,并且 zk 集群不能是單點。執行安裝 hdfsansible-playbook -i tdsql_hosts hdfs.ymlsu - tdsql用 tdsql 用戶初始化 hdfs 集群,初始化順序如下,初始化的工作只用做一次,不要重復初始化用 tdsql 用戶在 hdfs1 機器,格式化 zkhdfs zkfc -formatzk用 tdsql 用戶在所有機器,啟動 journalnodehdfs --daemon start journalnode用 tdsql 用戶在 hdfs1 機器,格式化并啟動 namenodehdfs namenode -formathdfs --daemon start namenode用 tdsql 用戶在 hdfs2 機器,格式化 namenodehdfs namenode -bootstrapstandby用 tdsql 用戶啟動 hdfs 集群,啟動順序如下,已經啟動的進程就不用重復再啟動了,查看啟動的進程”jps”在所有 hdfs 機器上啟動 journalnodehdfs --daemon start journalnode在 hdfs1 和 hdfs2 上啟動 namenodehdfs --daemon start namenode在 hdfs1 和 hdfs2 上啟動 zkfchdfs --daemon start zkfc在所有 hdfs 機器上啟動 datanodehdfs --daemon start datanode附:用 tdsql 用戶關閉 hdfs 集群,關閉順序如下在所有 hdfs 機器上關閉 datanodehdfs --daemon stop datanode在 hdfs1 和 hdfs2 上關閉 zkfchdfs --daemon stop zkfc在 hdfs1 和 hdfs2 上關閉 namenodehdfs --daemon stop namenode在所有 hdfs 機器上關閉 journalnodehdfs --daemon stop journalnode(7)在 hdfs 集群下查看/tdsqlbackup 路徑用 tdsql 用戶執行以下命令#查看/tdsqlbackup 目錄是否已經被自動創建,權限是否如下hadoop fs -ls /drwxr-xr-x - tdsql supergroup 0 2019-01-02 17:52 /tdsqlbackup如果目錄不在或者權限不對,用下面命令修改:hadoop fs -mkdir /tdsqlbackuphadoop fs -chown tdsql.supergroup /tdsqlbackup(8)管理 hdfs 集群用 tdsql 用戶執行以下命令查看所有 namenode 節點狀態,及主備情況(只適用于高可用 3 節點架構)hdfs haadmin -getallservicestate查看所有 datanode 節點的狀態,及上報的容量情況hdfs dfsadmin -report(9)注意用 tdsql 用戶執行 jps 命令,可以看到 hdfs 的進程名稱(只適用于高可用 3 節點架構)hdfs1 和 hdfs2 機器上應該看到 namenode、journalnode、datanode、dfszkfailovercontrollerhdfs3 機器上應該看到 datanode、journalnode(10)配置 hdfs 監控如果有 hdfs,但是沒有配置 hdfs 監控,到"“集群管理->集群配置”中設置“hdfs 服務列表”",注意:如上圖所示填寫 namenode 節點(一般 2 個)的 50070 端口生產環境不能用單節點 hdfs,單節點架構的 hdfs 的端口號是 9870 |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

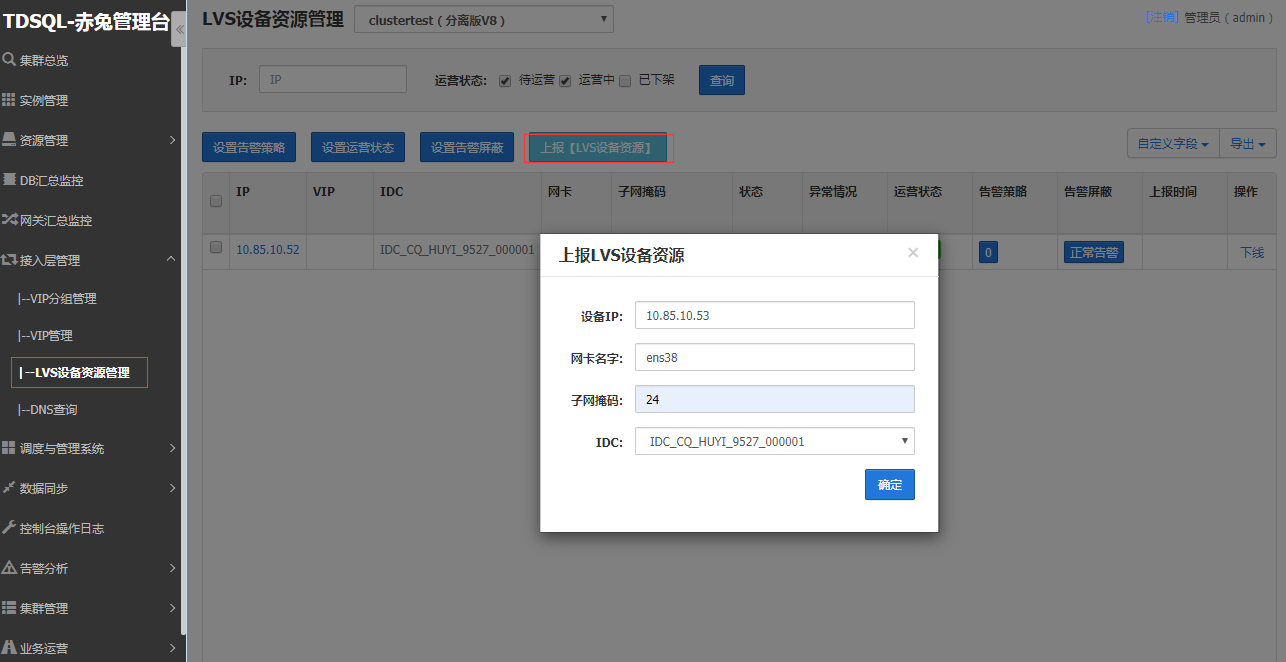

#安裝 lvslvs 機器建議單獨部署,不建議和別人復用(最多只能和 zk 復用)。(1)檢查 tdsql_hosts 文件vim tdsql_hosts[lvs] <—填入 lvs 地址,lvs 的數量固定為 2lvs1 ansible_ssh_host=10.85.10.52lvs2 ansible_ssh_host=10.85.10.53(2)安裝 lvsansible-playbook -i tdsql_hosts lvs.yml(3)赤兔前臺操作 lvs 接入層管理 -> lvs 設備資源管理 -> 上報 lvs 設備資源上報 lvs 機器信息(2 臺 lvs 機器信息都要上報)設備 ip:填入 lvs 機器的通信 ip 地址。網卡名字:通信網卡設備名。子網掩碼:填入實際的子網掩碼。idc:lvs 機器需要劃分到同一個 idc 中,比如這里的“idc_sz_ydgl_0401_000001”。 |

創建 vip(不能選取部署的機器 ip 作為 vip,需要另選之外一個)

vip:規劃一個 vip 的地址,vip 的地址要和 lvs 機器的通信 ip 地址在同一個網段內。

設備 ip 列表:填入 lvs 機器的通信 ip 地址,一行一個。

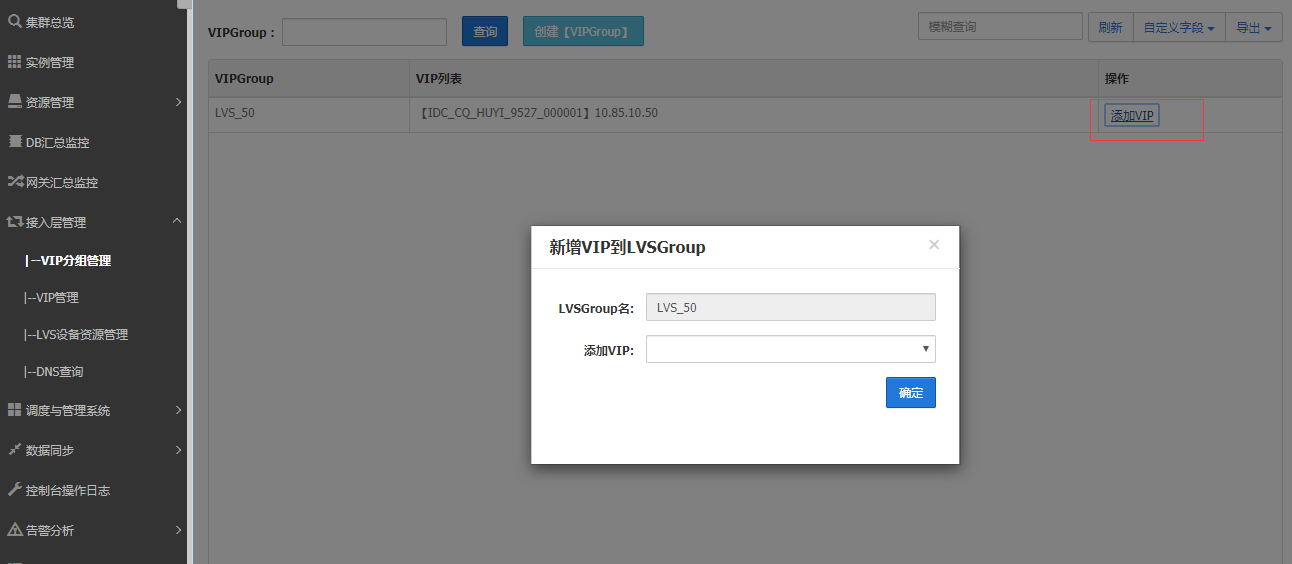

創建 vipgroup

vipgroup 名:新建一個 vipgroup,取一個有意義的名字。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

|

#安裝 kafka(1)檢查 tdsql_hosts 文件vim tdsql_hosts[kafka] <----填入 kafka 集群的地址,kafka 的數量固定為 3kafka1 ansible_ssh_host=10.85.10.51 <----kafka 機器的 java 虛擬機占用 3 個 g 以上內存kafka2 ansible_ssh_host=10.85.10.52kafka3 ansible_ssh_host=10.85.10.53(2)修改多源同步變量修改 group_vars/all 中下面的相關變量vim group_vars/allkafka_logdir: /mysql/log/kafka #日志要創建kafka目錄(3)執行安裝多源同步ansible-playbook -i tdsql_hosts kafka.yml(4)驗證是否安裝成功cd /data/application/kafka_2.12-2.3.1/logsvim server.log <----查看 kafka 啟動信息#安裝 consumer(1) 查看 tdsql_hosts 文件[consumer] <—填入消費者的地址,數量固定為 1consumer1 ansible_ssh_host=10.240.139.35(2)執行安裝 consumeransible-playbook -i tdsql_hosts consumer.yml(3)啟動消費者服務在 consumer 的機器上,使用下面命令啟動消費者服務cd /data/application/consumer/bin/./binlogconsumermgn --zklist 10.240.139.35:2181 --zkrootpath /noshard1 --kafkazklist 10.240.139.35:2181 --kafkazkrootpath /kafka --dev eth1參數說明:–zklist zk 的 ip:port,可以寫多個 zk ip:port,多個之間用英文逗號分隔–zkrootpath 注意整理 zk 根節點與部署的時候 group_vars/all 下的” zk_rootdir”一致–kafkazklist kafka 所在 zk,通常與–zklist 一樣–kafkazkrootpath kafka 在 zk 上的根節點,固定是/kafka–dev consumer 的網卡名稱例如:./binlogconsumermgn --zklist 10.85.10.51:2181,10.85.10.52:2181,10.85.10.53:2181 --zkrootpath /tdsqlzk --kafkazklist 10.85.10.51:2181,10.85.10.52:2181,10.85.10.53:2181 --kafkazkrootpath /kafka --dev ens38 |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

|

#安裝 es(1) 查看 tdsql_hosts 文件(不能與 chitu 同一臺機器)[es] <—填入 es 的地址,數量固定為 1es1 ansible_ssh_host=10.85.10.54修改變量文件 vim group_vars/alles_mem: 8 <-----內存占用,如果這里寫 8 則至少占用 8*2=16g 內存es_log_days: 7 <-----日志保留天數es_base_path: /data/application/es-install/es <-----es 數據存放路徑改為es_mem: 2es_log_days: 7es_base_path: /mysql/data/es-install/es(2)執行安裝 esansible-playbook -i tdsql_hosts es_single.yml(3)啟停命令(在 es 機器上操作):# stopps -ef |grep elasticsearch | grep -v ‘grep'| awk ‘{print $2}' | xargs kill -9ps -ef |grep logstash | grep -v ‘grep'| awk ‘{print $2}' | xargs kill -9ps -ef |grep es-cleaner | grep -v ‘grep'| awk ‘{print $2}' | xargs kill -9ps -ef |grep ‘node/bin/node' | grep -v ‘grep'| awk ‘{print $2}' | xargs kill -9# starttdsql 用戶啟動:cd /data/application/es-install/es/master/tools./start-elasticsearch.shcd /data/application/es-install/es/data/tools./start-elasticsearch.shroot 用戶啟動:cd /data/application/es-install/logstash/tools./start-logstash.shcd /data/application/es-install/es-cleaner./start-es-cleaner.shcd /data/application/es-install/kibana-5.6.4-linux-x86_64/bin/nohup ./kibana &# 檢測是否正常啟動ps -ef |grep elasticsearch | grep -v ‘grep' |wc -l輸出為:4 <--------我的單個es 個數為0ps -ef |grep logstash | grep -v ‘grep' |wc -l輸出為:2ps -ef |grep es-cleaner | grep -v ‘grep' |wc -l輸出為:1ps -ef |grep ‘node/bin/node' | grep -v ‘grep' |wc -l輸出為:1(3)es 的驗證及相關配置輸入 es ip 地址,打開 es 前臺頁面。啟動 es 后,需要把實例詳情中的“網關審計數據是否入庫”打開,選擇“是”。只有在打開這個開關后的日志才會入 es,為了可以定位問題,需要的話一定要盡早打開。 |

至此,tdsql所有模塊已部署完成,后期可以直接使用和測試了。

到此這篇關于tdsql 安裝部署附圖的實現(圖文)的文章就介紹到這了,更多相關tdsql 安裝部署內容請搜索服務器之家以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持服務器之家!

原文鏈接:https://www.cnblogs.com/cqdba/p/13704465.html