機器學習算法中回歸算法有很多,例如神經網絡回歸算法、蟻群回歸算法,支持向量機回歸算法等,其中也包括本篇文章要講述的梯度下降算法,本篇文章將主要講解其基本原理以及基于spark mllib進行實例示范,不足之處請多多指教。

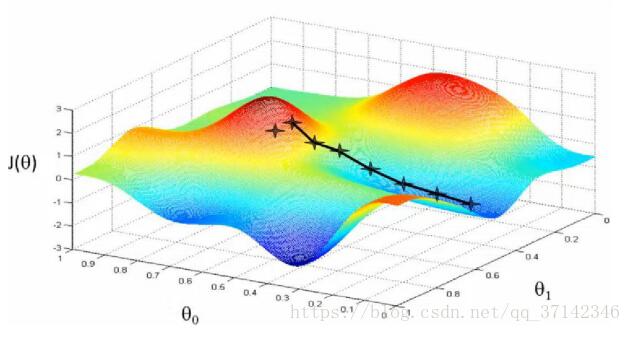

梯度下降算法包含多種不同的算法,有批量梯度算法,隨機梯度算法,折中梯度算法等等。對于隨機梯度下降算法而言,它通過不停的判斷和選擇當前目標下最優的路徑,從而能夠在最短路徑下達到最優的結果。我們可以在一個人下山坡為例,想要更快的到達山低,最簡單的辦法就是在當前位置沿著最陡峭的方向下山,到另一個位置后接著上面的方式依舊尋找最陡峭的方向走,這樣每走一步就停下來觀察最下路線的方法就是隨機梯度下降算法的本質。

隨機梯度下降算法理論基礎

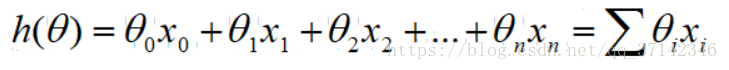

在線性回歸中,我們給出回歸方程,如下所示:

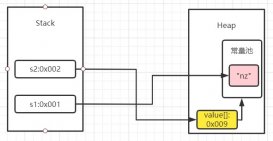

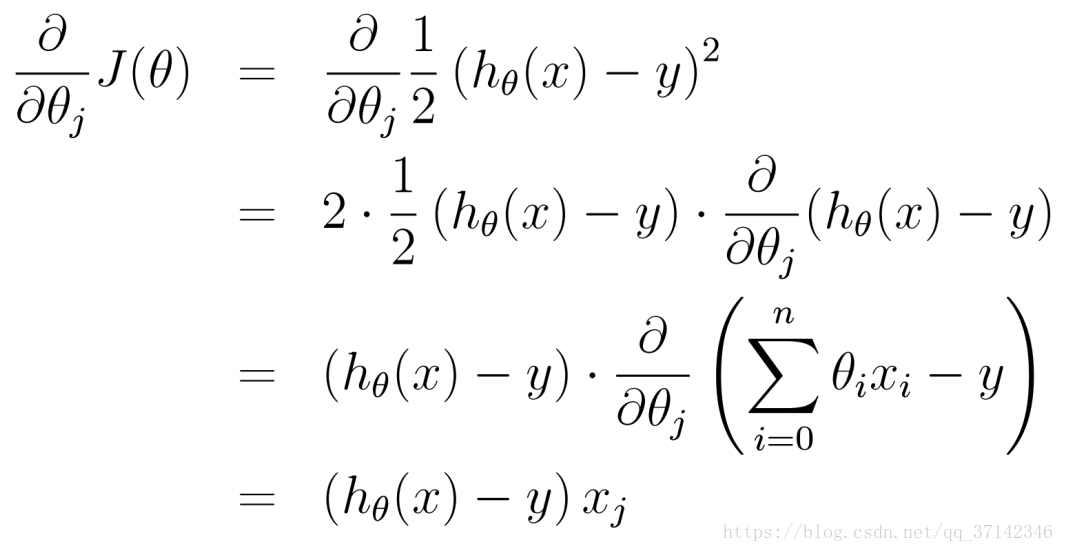

我們知道,對于最小二乘法要想求得最優變量就要使得計算值與實際值的偏差的平方最小。而隨機梯度下降算法對于系數需要通過不斷的求偏導求解出當前位置下最優化的數據,那么梯度方向公式推導如下公式,公式中的θ會向著梯度下降最快的方向減少,從而推斷出θ的最優解。

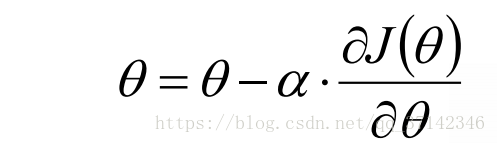

因此隨機梯度下降法的公式歸結為通過迭代計算特征值從而求出最合適的值。θ的求解公式如下。

α是下降系數,即步長,學習率,通俗的說就是計算每次下降的幅度的大小,系數越大每次計算的差值越大,系數越小則差值越小,但是迭代計算的時間也會相對延長。θ的初值可以隨機賦值,比如下面的例子中初值賦值為0。

spark mllib隨機梯度下降算法實例

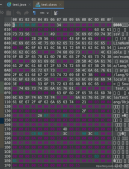

下面使用spark mllib來迭代計算回歸方程y=2x的θ最優解,代碼如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

|

package cn.just.shinelon.mllib.algorithmimport java.utilimport scala.collection.immutable.hashmap/** * 隨機梯度下降算法實戰 * 隨機梯度下降算法:最短路徑下達到最優結果 * 數學表達公式如下: * f(θ)=θ0x0+θ1x1+θ2x2+...+θnxn * 對于系數要通過不停地求解出當前位置下最優化的數據,即不停對系數θ求偏導數 * 則θ求解的公式如下: * θ=θ-α(f(θ)-yi)xi * 公式中α是下降系數,即每次下降的幅度大小,系數越大則差值越小,系數越小則差值越小,但是計算時間也相對延長 */object sgd { var data=hashmap[int,int]() //創建數據集 def getdata():hashmap[int,int]={ for(i <- 1 to 50){ //創建50個數據集 data += (i->(2*i)) //寫入公式y=2x } data //返回數據集 } var θ:double=0 //第一步 假設θ為0 var α:double=0.1 //設置步進系數 def sgd(x:double,y:double)={ //隨機梯度下降迭代公式 θ=θ-α*((θ*x)-y) //迭代公式 } def main(args: array[string]): unit = { val datasource=getdata() //獲取數據集 datasource.foreach(mymap=>{ //開始迭代 sgd(mymap._1,mymap._2) //輸入數據 }) println("最終結果值θ為:"+θ) }} |

需要注意的是隨著步長系數增大以及數據量的增大,θ值偏差越來越大。同時這里也遺留下一個問題,當數據量大到一定程度,為什么θ值會為nan,筆者心中有所疑惑,如果哪位大佬有想法可以留言探討,謝謝!

以上就是本文的全部內容,希望對大家的學習有所幫助,也希望大家多多支持服務器之家。

原文鏈接:https://blog.csdn.net/qq_37142346/article/details/80715673